ビジョンセンサ搭載で、周辺環境を認識

疾走4足歩行ロボット

ALIANGO

・ 最大荷重 : 5-10kg

・ 最大傾斜角度 : 20°

・ 最高速度 : 1.5 - 2 m/s

・ トルクセンサ : 4

~ オプション ~

・ リアルタイム3次元マップ生成

及びナビゲーション機能

・ リアルタイムで周辺の障害物の認識

・ 人の姿勢の認識

・ 人の骨格の認識

・ ターゲット人物の追尾

・ 顔認証(開発中)

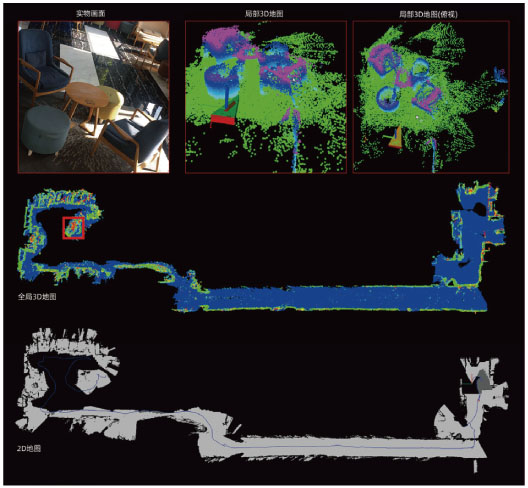

Depth Vision - 3Dマップリアルタイム生成及びナビゲーション機能

・ 3次元環境生成

ロボットは、ビジョンセンサ(カメラ)を使用して、周辺環境の

色の情報と深度の情報を収集してから、3次元の空間情報を構築

します。この処理は、特殊なビジョンアルゴリズムにより行われ

ます。

・ 予測地図

ビジュアルセンサを使用(カメラ)して、ロボットの周辺地図が

生成され、障害物のデータが提供されます。

・ ダイナミック障害物認識

ロボットが、移動する障害物に遭遇した場合、現在のマップデータ

を更新して、不要な情報を取り除きます。

・ グローバルポジショニング

地図の作成の際、グローバル及びローカルのリアルタイム

ポジショニング機能を実施します。

地図表示モジュールはカメラの見ている場所をリアルタイムで

認識し、ズームイン、ズームアウト、任意の回転等をサポート

します。

・ ループ検知

ロボットは、高いループバック精度を、多くのアプリケーションで提供する事が

でき、特定のレンジでの位置精度や、特定の振動率、ドリフトやロスの際に安定性を

提供出来ます。

人の姿勢及び顔認識

・ 人の姿勢認識

カラーカメラは、ロボットの視野の中にいる人の情報を収集する事ができ、ディープラーニングモデルを使用して

人の特定のジェスチャを認識する事が出来ます。これにより人とロボットのインタラクションを可能にします。

立ち上がる、しゃがむ、前進する、後進する、ツイストする等の動作をロボットが真似る事が出来ます。

・ 人の骨格認識

カメラの視野からの色情報から、ロボットは2次元の人の骨格情報を算出出来、更なる3次元の情報を深度を使用して

算出する事が出来ます。

それにより、ターゲットの動作情報を基に、3次元の骨格データを使用して、次の動作を予測する事が出来ます。

・ ターゲット人物のトラッキング

1人以上が同じ場面にいる場合、例えば左手を挙げる等、ロボットにある種の動作を教えると、ロボットはターゲット

をロックし、骨格情報を識別します。その後、ロボットはターゲットの位置を追尾し、リアルタイムでターゲットの

動作を認識する事が出来ます。

・ 顔認証及び外見判断(現在開発中)

ロボットの視野の中で、人工知能アルゴリズムにより、人の顔認証、混雑の判断、性別判断、年齢判断、服装等を

識別出来ます。

仕様

| 重量 | 約 19 kg |

| 寸法 (LxWxH):立位 | 650 x 310 x 600 mm |

| 寸法 (LxWxH):座位 | 450 x 310 x 250 mm |

| 耐荷重 | 5 - 10 kg |

| 歩行速度 | 1.5 - 2.0 m/秒 |

| 最大傾斜 | 20° |

| 駆動時間 | 2 - 4 時間 |

| 電池容量 | 10000 mAH*26V |

| 合計自由度 | 12 |

| 保護モード | 緊急停止、オーバーヒート、落下保護 |

| 警報システム | 電圧、温度、回路、充電警報 |

| RTOS | モーション制御 : Ubuntu 環境認識 : Ubuntu-ROS |

| モーション機能サポート | 1.平地を歩く 2.階段を上下に移動 3.落下してから回復 4.歩行・走行の定義 5.その他の歩き方の定義 |

| ビジュアル視野(オプション) | 1.マッピング、ポジショニング、ナビゲーション、 障害物回避の為のLiDar及産業用PCを搭載可能です。 2.物体・動作解析用、精度の高いマッピング用に 深度カメラを搭載出来ます。 |

ダウンロード

copyright (C) Nihon Binary Co., Ltd., All rights reserved.